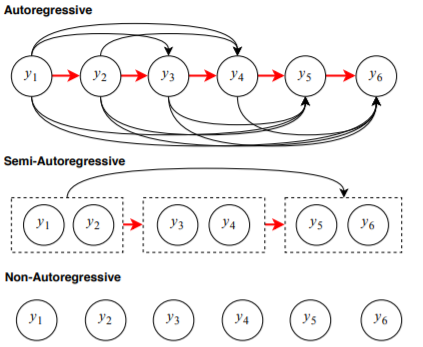

从题目就可以看出来,本文将要介绍一种半自动回归的机器翻译解码技术。之前我们介绍了各种非自动回归的解码技术,其中有一个Latent Transformer是先用auto-regression生成一个短序列,然后用这个短序列并行生成目标序列。当时我们说这其实算是一种半自动回归的方法。今天我们要介绍另一种半自动回归的方法——SAT。

和Latent Transformer不同,Semi-Auto regressive Transformer (SAT)仍然是auto-regression的运行机制,但是不像auto-regression那样一次生成一个元素,SAT是一次生成多个元素。

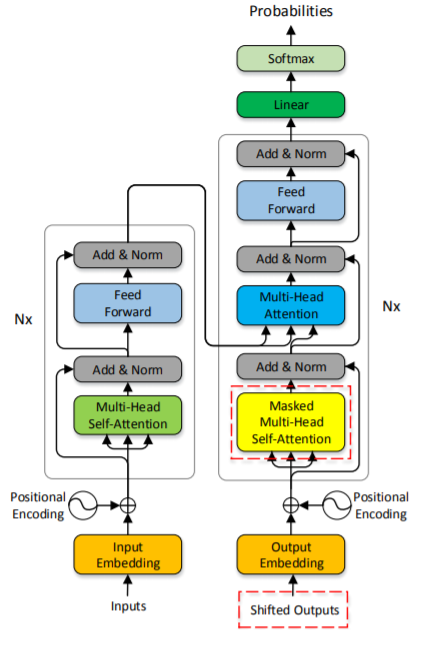

1. 模型结构

模型结构如图。我们可以看到模型基本上和Transformer保持一致,只在图中红虚线框中有所改变。

1.1 Group-Level Chain Rule

给定一个目标序列,通常的建模方式是词级别的链式法则:

每个词都依赖之前的词。在SAT中,对序列进行分组

其中$K$表示每组的大小,$K$越大 表示并行能力越强,除了最后一组其他每组中必须包含$K$个词。这样的话,上面的链式法则则变成:

作者将之前的auto-regression称之为short-distance prediction,而将SAT称之为long-distance prediction。

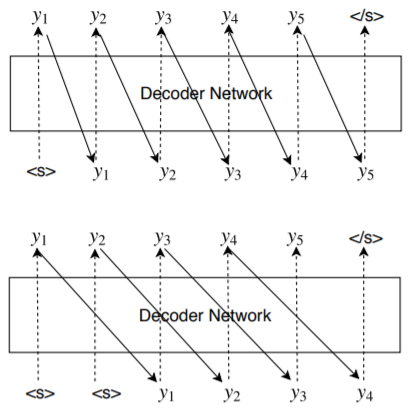

1.2 Relaxed Causal Mask

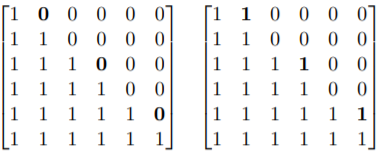

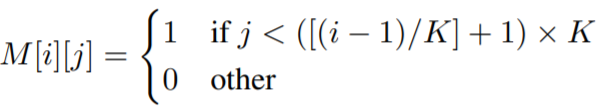

在Transformer中由于是连续的词矩阵,因此在做mask的时候直接使用下三角矩阵,但是在SAT中由于答对词进行了分组,再使用下三角矩阵就不合适了,作者这里提出一个粗粒度下三角矩阵(coarse-grained lower triangular matrix)的 mask矩阵。如图所示:

图中左边表示标准的下三角矩阵,右边表示粗粒度下三角矩阵。

数学形式:

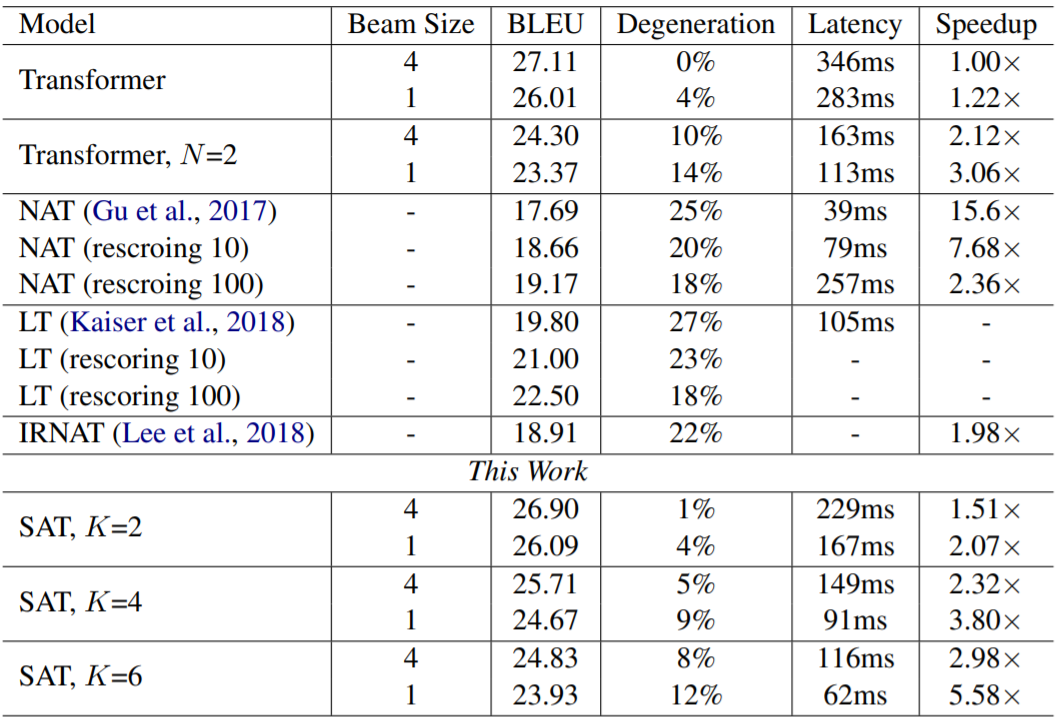

2. 实验结果